В чем проблема?

В соцсетях распространяются посты, которые пользователи иллюстрируют эмоциональными "фото". В основном тематика такого контента военная: о военных, последствиях разрушений в Украине, страданиях гражданских. Однако объединяет их не только тема, но и то, что все эти "фото" не реальны. Они созданы с помощью искусственного интеллекта.

Пример сгенерированного изображения в Тиктоке

Недавний пример, ставший вирусным на всех площадках Meta, — это изображение двух котиков, оказавшихся между завалами после российских обстрелов наших городов. Часть пользователей поняла, что это искусственно созданный контент, а часть поверила в его подлинность и в самом деле сочувствовала, фокусируя внимание на том, как от войны страдают животные.

Пример поста в Фейсбуке

Но не котиками едиными. До этого в украинском инфопространстве уже возникали скандальные случаи использования сгенерированных изображений. Один из них — неправильное освещение такого контента, как это произошло с информагентством "УНИАН". Агентство промаркировало сгенерированный контент как реальные фото, после чего отдельные медиа сделали репост новости с такой же маркировкой. Многие читатели поверили в подлинность изображений.

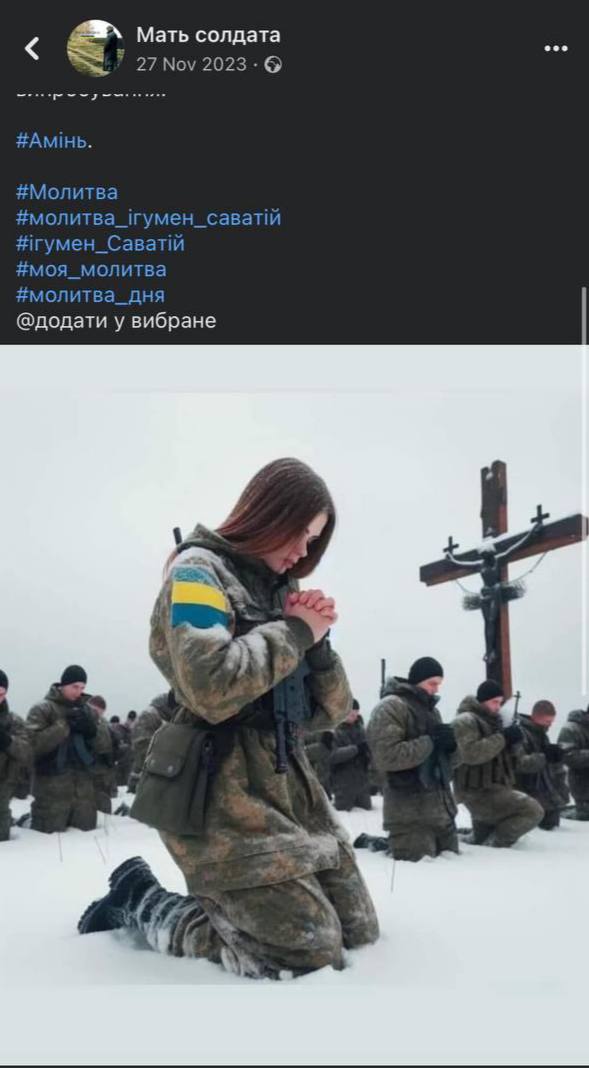

Еще одни сгенерированные ИИ украинцы

Неопытным в теме искусственного интеллекта пользователям может быть трудно отличить реальные фотографии от сгенерированных. Поскольку те часто выглядят достаточно правдоподобно. Например, как в этом посте, где изображены украинские военные.

Если хорошо рассмотреть фотографию, можно заметить, что лица у военных сзади нечеткие. Флаг на руке девушки состоит из трех цветов, а не двух. У девушки анатомически неправильно сложены руки и нет большого пальца. Камуфляж военных похож на российский, а не украинский, и нет опознавательных шевронов или нашивок.

Еще одним примером является пост с изображением малыша, который якобы выжил после обстрелов Днепра. Фотография распространилась на большую аудиторию и вызвала шквал эмоциональных комментариев.

Однако само изображение (несмотря на очевидные подсказки, которые намекают на искусственность) выглядит несколько заблюренным, отретушированным и словно нарисованным, что является прямым доказательством того, что оно ненастоящее.

Татьяна Авдеева, экспертка по искусственному интеллекту и медиаграмотности, старшая юристка Лаборатории цифровой безопасности, комментирует — такие изображения перегружают нашу ленту очень чувствительной информацией, сильно влияющей на психологическое состояние личности и, как следствие, информационную среду. Она становится негативной, но не на основании реальных событий, а на основании сгенерированного контента — искусственное создание отрицательного информационного поля.

Нередко сами пользователи не видят проблемы в том, чтобы использовать именно сгенерированные эмоциональные изображения в противовес реальным. Мол, такие фотографии иллюстративны и в любом случае отражают реальность такой, какой она есть.

Какое решение?

Запретить использовать достояние искусственного интеллекта обычному пользователю — это не выход. Гораздо действеннее объяснить ответственность каждого отдельного пользователя за свой цифровой след.

Цифровой след — это все данные, которые вы когда-либо оставляли в интернете. Будь то пост, который вы прокомментировали в 2015 году, будь то реклама, на которую вы переходили при просмотре сайтов, или ложное изображение, которое вы распространили. Эта информация не исчезает бесследно. Фраза "что однажды попало в интернет, остаётся там навсегда" иллюстрирует принцип работы сети — все действия в цифровом мире сохраняются и имеют последствия. Именно поэтому следует осознанно относиться к тому, что вы публикуете, просматриваете, комментируете и т.д.

Татьяна говорит, прежде всего, следует помнить, что, независимо от того, кто является субъектом, определенный вид контента запрещен для распространения всем. Это язык вражды, пропаганда войны, распространение предвыборной агитации с нарушением правил ее распространения. За это человек может отвечать на индивидуальном уровне.

Татьяна Авдеева. Фото из личного архива спикерки

Во-вторых, неправильно полагать, что если у вас недостаточно большая аудитория в соцсетях, то ваш голос незаметен. Работа алгоритмов и трендов онлайн-платформ заточена на то, чтобы каждый голос мог быть услышан. Например, в Твиттере сообщение аккаунта даже с 20 подписчиками может завируситься благодаря репостам.

"И, с одной стороны, это классно. Например, в авторитарных государствах, где пытаются преследовать активистов, журналистов, правозащитников и не дают высказываться, такая функция помогает им все же достучаться до аудитории с качественной правдивой информацией", — рассказывает специалистка.

Ваш цифровой голос выходит далеко за пределы вашей страницы, а несколько сливающихся воедино голосов несут мощное влияние и могут формировать информационное пространство.

Как это работает?

Всегда ли генерирование контента искусственным интеллектом — это негативное явление

Экспертка рассказывает, иногда использование сгенерированных нейросетью изображений подкреплено хорошей мотивацией — защитить приватность.

"Многие реальные изображения содержат персональные данные, не всегда эти изображения являются приятными и не всегда человеку, который на них изображен, хочется попадать на первые полосы. Поэтому, например, медиа могут использовать этот принцип. Это, опять же, если мы говорим о добросовестных мотивах защитить персональные данные", — говорит специалистка и добавляет, если все же взвесить преимущества и вред такого решения, то вред от последствий будет преобладать, поэтому нужно быть особенно осторожными с этим.

Сам искусственный интеллект также не является полностью творением ада: он помогает автоматизировать процессы, воплощать в жизнь вещи, о которых мы раньше только могли мечтать. Например, персонаж из фильма "Хоббит" Голум был искусственно сгенерирован компьютерной системой. На актера надевали костюм с многочисленными точками, а затем на них накладывали изображение.

"Есть множество вариантов использования ИИ для позитива, вопрос в том, чтобы у нас была регулировка того, где пролегают красные линии, и были стандарты, что делать можно, а что нельзя", — заключает Татьяна.

Последствия использования таких изображений

Прежде всего, когда мы привыкаем к эмоциональным гиперболизированным изображениям, есть риск того, что обычные фотографии реальности больше не будут поражать нас — мы не будем считать их столь показательными, как сгенерированные.

Если же говорить о правовых последствиях как для отдельного человека, так и для медиа — это возможная потеря доверия.

"Когда начинается генерирование контента без предупреждения или генерирование контента на чувствительные темы, это способствует тому, что к медиа создается пузырь недоверия и в долгосрочной перспективе это достаточно опасно. Это сильно подрывает попытку создать имидж надежности медиа", — рассказывает специалистка.

Она добавляет, что следствием таких действий может стать то, что и иностранцы, и украинцы будут воспринимать медиа как ненадежный источник информации. Добросовестным медиа на этой основе станет труднее работать, поскольку понадобится каждый раз доказывать, что их информация правдива.

Также есть риск, что ваше сгенерированное изображение на чувствительную тему, которую вы подписали как "сгенерированное ИИ", распространят другие пользователи без этого примечания. И в какой-то момент люди не будут знать, что это искусственно сгенерированный контент, а будут распространять, веря в подлинность.

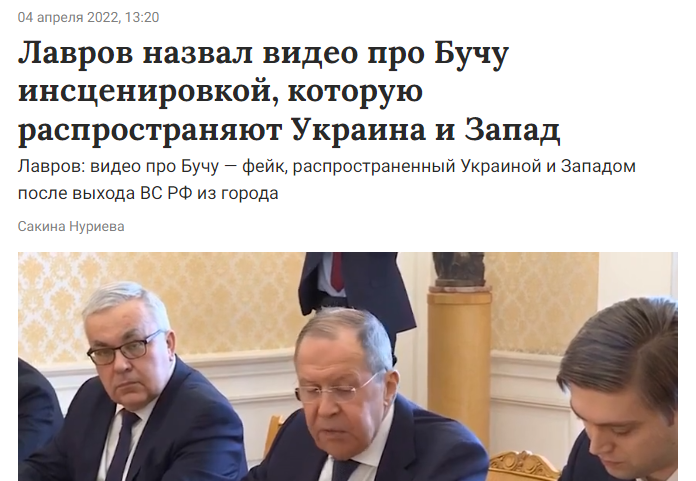

Как российская пропаганда использует посты пользователей для распространения антиукраинских нарративов

Татьяна объясняет, хуже всего, когда наши посты со сгенерированными нейросетью изображениями использует российская пропаганда: "Россияне начинают говорить, что украинцы сознательно создают ложный контент, чтобы распространять дезинформацию о российских действиях в Украине. И впоследствии на основании этого будут утверждать, что любые фото и информация — это постановка. Думаю, все помнят, когда россияне пытались массово разгонять идею того, что фотографии из Мариуполя — постановка".

Такие нарративы влияют на иностранцев и формируют у них пристрастное мнение о российско-украинской войне. В частности, россияне распространяли среди иностранцев манипуляции, что ужасные фото убитых украинцев из Бучи и Ирпеня — это "инсценирование киевского режима для западных медиа", чем действительно повлияли на часть иностранных пользователей, которые с недоверием восприняли эти кадры

"Чем больше мы будем создавать сгенерированный контент, связанный с войной, тем больше будет распространяться этот тезис (что все фото из Украины — это постановка) и тем более валидным он будет. Ведь если уже есть сгенерированный контент со стороны украинцев, тогда почему реальные фотографии военных преступлений также не могут быть сгенерированными? Медиа я бы не советовала генерировать что-то на чувствительные темы, потому что это будет еще больше размывать понятие того, что реально, а что нереально", — комментирует экспертка.

Юристка делится, по этой теме они с командой много сотрудничают с международными медиа и межправительственными организациями, чтобы постоянно опровергать нарративы и доказывать, что украинские медиа не предвзяты, соблюдают стандарты, надежны, освещают информацию такой, какой она есть.

"И если украинские медиа будут распространять сгенерированный контент, то будет все труднее с этим взаимодействовать, будет сложнее продвигать идею, что можно брать информацию из украинских медиа, а не полагаться только на ресурсы собственных международных расследователей, репортеров и так далее", — добавляет она.

Этично ли использовать сгенерированные изображения?

Нейросеть тренируется генерировать изображение на основе уже ранее созданного человеком контента. Поэтому в инфопространстве не угасает дискуссия — этично ли использовать искусственный интеллект, когда он бесплатно и без согласия авторов использует их работы в своих целях.

Специалистка отвечает, вопрос открытый и сложный: "Я бы сказала, что вопрос даже не в использовании изображений и фото как таковых, а в том, как программируется система. К примеру, когда мы просим сгенерировать нам что-то, то неизвестно, на основе каких конкретно вводных данных, кусочков, генерируется конкретное изображение. Мы можем попросить сгенерировать замок с единорогами и не знаем, чье именно фото замка, чью картину единорога возьмет система, кто именно будет автором этих материалов, на основе которых будет генерироваться наше изображение".

Если мы генерируем сами, здесь вопрос не только этики, но и соблюдения законодательства об авторском праве. Чтобы использовать в информационных целях какую-либо информацию, нам нужно разрешение автора.

Механизмы регуляции

Все имеющиеся механизмы регуляции рассчитаны на работу разработчиков онлайн-платформ. К примеру, Совет Европы разрабатывает проект об искусственном интеллекте, в котором решение регуляции предусматривает маркировку контента, но именно конечными пользователями, что частично снимает эту обязанность с компаний. Проект говорит, что компании должны обеспечивать принцип прозрачности, чтобы пользователи понимали, что они взаимодействуют с искусственным интеллектом и автор продукта — искусственный интеллект, и обеспечить пользователей инструментами для маркировки.

Такие компании как Фейсбук, Твиттер, Гугл, Майкрософт уже вводят маркировку, но пока на уровне бета-тестирования. Например, Майкрософт предлагает функцию наложения на каждый аутентичный контент аналога электронной цифровой подписи. "Если публичные лица будут выпускать заявления, то технически это не будет какой-то визуально видимый водяной знак, а, по сути, часть кода загруженного видео и т.д. И можно будет проверить, совпадает ли этот код с ключом, который является публично доступным. Сгенерированный контент как раз этой подписи оригинальности иметь не будет", — рассказывает юристка. Она предлагает и другой вариант — отмечать посты по типу, как сейчас отмечается политическая реклама или оплаченный пост. Однако все эти решения ориентированы на добросовестных авторов.

А как в Украине?

В Украине, с правовой точки зрения, точки зрения этики и Закона о медиа, пока нет ответов, как квалифицировать сгенерированный контент. А также можно ли его считать надежным и правдивым. Татьяна считает, несмотря на это, мы двигаемся в направлении регуляции. К примеру, Минцифры, как один из шагов, давало рекомендации об ответственности применения искусственного интеллекта в медиа.

Вскоре в стране также имплементируют Акт о цифровых услугах (одна из целей которого — обеспечить регуляцию контента и его прозрачность на онлайн-платформах). Несмотря на то, что они общие и базовые, это решение вводит функцию института доверенных партнеров. Пока такие есть в Meta: Цифролаба, Internews Украина и некоторые другие. Это организации, с которыми платформы тесно сотрудничают для того, чтобы можно было улучшать модерационные политики, решать спорные вопросы. Например, когда сносили хештеги "#Буча, #Ирпень", Цифролаба активно продвигала то, чтобы перестали блокировать публикации только на основании конкретного слова. И чтобы эти посты со свидетельствами совершения военных преступлений восстановили.

Экспертка считает, что решение будет предлагаться, но на это нужно время. А пока отслеживать и регулировать сгенерированный контент скорее в ручном режиме.

Советы пользователям, как самостоятельно распознать сгенерированный контент

Проанализировать странные изменения в изображении, обращать внимание на:

- То, как выглядят серьги, украшения, как вообще выглядят уши — все, что находится вне овала лица.

Серьги на таких фотографиях обычно расплывчаты. Фото: How to recognize fake AI-generated images, Kyle McDonald

- Как выглядит фон — ничего ли не "поехало", не расплылось.

- Одежда — правильно ли расположена молния, есть ли на худи завязки, нигде ли они не перебиваются.

- Волосы — не съехали ли пряди, натурально ли они выглядят.

Фото: How to recognize fake AI-generated images, Kyle McDonald

- Как выглядят зрачки, так, например, можно определять дипфейки (наложение изображения на видео).

Экспертка приводит пример: в начале полномасштабного вторжения неизвестные сделали маску Кличко и созванивались с мэрами других городов Европы: Барселоны, Берлина и еще нескольких. Разговоры продолжались до 30 минут, пока стало ясно, что это говорит не Кличко. Потому что нарративы, которые он говорил, абсолютно не совпадали с реальной позицией Киева. Плюс фильтры, наложенные в режиме реального времени, обычно не успевают адаптироваться к быстрому изменению движения или отражению изображения — они "лагают". Поэтому можно попросить человека повернуть голову, если видео транслируется в режиме реального времени. Или уже готовое видео проанализировать в специальных приложениях.

- Эффект рисунка или блюра на изображении. Выглядят ли поверхности и лица глянцевыми, словно отретушированными.

И самый главный совет — если вы сомневаетесь в правдивости информации, не распространяйте ее бездумно. Соблюдайте правила медиаграмотности и не засоряйте свой цифровой след.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.