У чому проблема?

Соцмережами ширяться дописи, які користувачі ілюструють емоційними "фото". Здебільшого тематика такого контенту воєнна: про військових, наслідки руйнувань в Україні, страждання цивільних. Однак об'єднує їх не лише тема, а й те, що всі ці "фото" не є реальними. Вони створені за допомогою штучного інтелекту.

Приклад згенерованого зображення у Тіктоці

Нещодавній приклад, який став вірусним на всіх майданчиках Meta, — це зображення двох котиків, які опинилися між завалами після російських обстрілів наших міст. Частина користувачів зрозуміла, що це штучно створений контент, а частина повірила в його справжність і справді співчувала, фокусуючи увагу на тому, як від війни страждають тварини.

Приклад допису в Фейсбуці

Та не котиками одними. До цього в українському інфопросторі вже виникали скандальні випадки використання згенерованих зображень. Один з них — неправильне висвітлення такого контенту, як це сталося з інформаційною агенцією "УНІАН". Агенція промаркувала згенерований контент як реальні фото, після чого окремі медіа зробили репост новини з таким же маркуванням. Багато читачів повірили в справжність зображень.

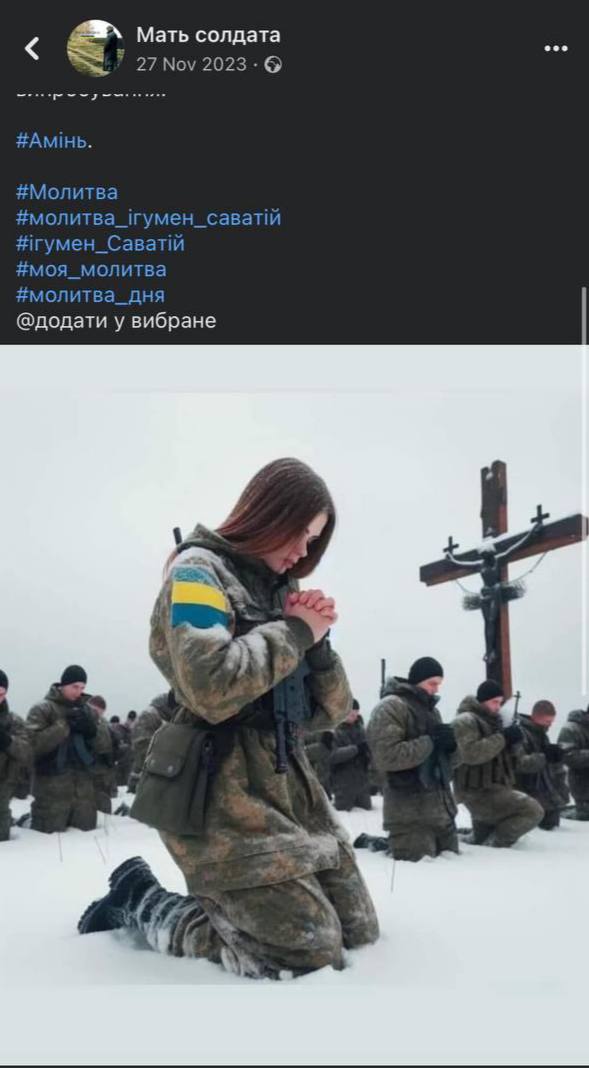

Ще одні згенеровані ШІ українці

Недосвідченим у темі штучного інтелекту користувачам справді може бути важко відрізнити реальні світлини від згенерованих. Оскільки ті часто виглядають доволі правдоподібно. Наприклад, як у цьому дописі, де наче зображені українські військові.

Якщо добре роздивитися світлину, можна помітити, що обличчя у військових позаду нечіткі. Прапор на руці дівчини складається з трьох кольорів, а не двох. У дівчини анатомічно неправильно складені руки й немає великого пальця. Камуфляж військових схожий на російський, а не український, і немає розпізнавальних шевронів чи нашивок.

Ще одним прикладом є допис з зображенням малюка, який начебто вижив після обстрілів Дніпра. Світлина поширилася на велику авдиторію та викликала шквал емоційних коментарів.

Однак саме зображення (попри очевидні підказки, які натякають на штучність) виглядає дещо заблюреним, відретушованим і наче намальованим, що є прямим доказом того, що воно несправжнє.

Тетяна Авдєєва, експертка зі штучного інтелекту та медіаграмотності, старша юристка Лабораторії цифрової безпеки, коментує — такі зображення перевантажують нашу стрічку дуже чутливою інформацією, яка сильно впливає на психологічний стан особи й, як наслідок, інформаційне середовище. Воно стає негативним, але не на підставі реальних подій, а на підставі згенерованого контенту — штучне створення негативного інформаційного поля.

Нерідко самі користувачі не бачать проблеми в тому, щоб використовувати саме згенеровані емоційні зображення на противагу реальним. Мовляв, такі світлини є ілюстративними й у будь-якому випадку відображають реальність такою, якою вона є.

Яке рішення?

Заборонити використовувати надбання штучного інтелекту звичайному користувачеві — це не вихід. Набагато дієвіше — пояснити відповідальність кожного окремого користувача за свій цифровий слід.

Цифровий слід — це всі дані, які ви коли-небудь залишали в інтернеті. Чи то допис, який ви прокоментували у 2015 році, чи реклама, на яку ви переходили під час перегляду сайтів, чи неправдиве зображення, яке ви поширили. Ця інформація не зникає безслідно. Фраза "що одного разу опинилося в інтернеті, залишається там назавжди" ілюструє принцип роботи мережі — всі дії в цифровому світі зберігаються й мають наслідки. Саме тому варто усвідомлено ставитись до того, що ви публікуєте, переглядаєте, коментуєте тощо.

Тетяна говорить, передусім варто пам'ятати, що, незалежно від того, хто є суб'єктом, певний вид контенту заборонений для поширення всім. Це мова ворожнечі, пропаганда війни, поширення передвиборчої агітації з порушенням правил її поширення тощо. За це людина може нести відповідальність на індивідуальному рівні.

Тетяна Авдєєва. Фото з особистого архіву спікерки

По-друге, неправильно вважати, що якщо у вас недостатньо велика авдиторія в соцмережах, то ваш голос непомітний. Робота алгоритмів та трендів онлайн-платформ заточена на те, щоб кожен голос міг бути почутим. Наприклад, у Твіттері допис акаунта навіть з 20 підписниками може завіруситися завдяки репостам.

"І, з одного боку, це класно. Наприклад, в авторитарних державах, де намагаються переслідувати активістів, журналістів, правозахисників і не дають висловлюватися, така функція допомагає їм все ж достукатися до авдиторії з якісною правдивою інформацією", — розповідає спеціалістка.

Ваш цифровий голос виходить далеко за межі вашої сторінки, а декілька голосів, які зливаються воєдино, несуть потужний вплив та можуть формувати інформаційний простір.

Як це працює?

Чи завжди генерування контенту штучним інтелектом — це негативне явище

Експертка розповідає, іноді використання згенерованих нейромережею зображень підкріплене хорошою мотивацією — захистити приватність.

"Багато реальних зображень містять персональні дані, не завжди ці зображення є приємними й не завжди людині, яка на них зображена, хочеться потрапляти на перші шпальти. Тому, наприклад, медіа можуть послуговуватися цим принципом. Це, знову ж таки, якщо ми говоримо про добросовісні мотиви захистити персональні дані", — говорить фахівчиня й додає, якщо все ж зважити переваги та шкоду такого рішення, то шкода від наслідків переважатиме, тому потрібно бути особливо обережними з цим.

Сам штучний інтелект також не є повністю витвором пекла: він допомагає автоматизовувати процеси, втілювати в життя речі, про які ми раніше тільки могли мріяти. Наприклад, персонаж з фільму "Гобіт" Ґолум був штучно згенерованим комп'ютерною системою. На актора одягали костюм з багатьма точками, а потім на них накладали зображення.

"Є безліч варіантів використання ШІ для позитиву, питання в тому, щоб у нас було регулювання того, де пролягають червоні лінії, і були стандарти, що робити можна, а що не можна", — підсумовує Тетяна.

Наслідки використання таких зображень

Перш за все, коли ми звикаємо до емоційних гіперболізованих зображень, є ризик того, що звичайні світлини реальності більше не вражатимуть нас — ми не вважатимемо їх настільки показовими, як згенеровані.

Якщо ж говорити про правові наслідки як для окремої людини, так і для медіа — це можлива втрата довіри.

"Коли починається генерування контенту без попередження або генерування контенту на чутливі теми, це сприяє тому, що до медіа створюється бульбашка недовіри й у довготривалій перспективі це досить небезпечно. Це сильно підриває спробу створити імідж надійності медіа", — розповідає фахівчиня.

Вона додає, наслідком таких дій може стати те, що і іноземці, і українці будуть сприймати медіа як ненадійне джерело інформації. Добросовісним медіа на цьому підґрунті стане важче працювати, оскільки знадобиться щоразу доводити, що їхня інформація правдива.

Також є ризик, що ваше згенероване зображення на чутливу тему, яку ви підписали як "згенероване ШІ", поширять інші користувачів без цієї примітки. І в якийсь момент люди не будуть знати, що це штучно згенерований контент, а поширюватимуть, вірячи в автентичність.

Як російська пропаганда використовує дописи користувачів для поширення антиукраїнських наративів

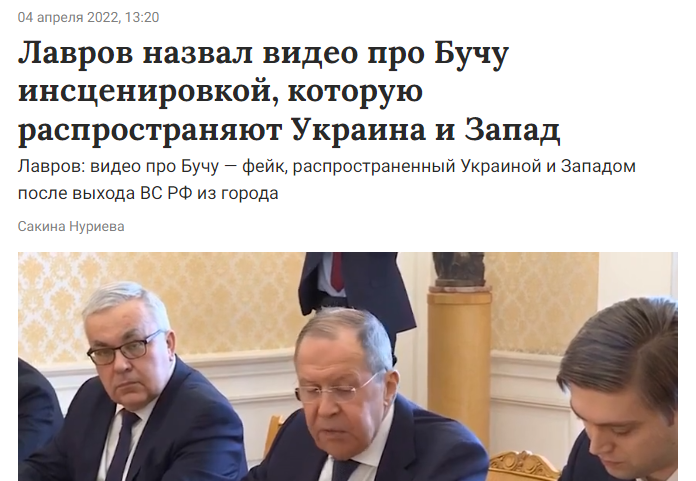

Тетяна пояснює, найгірше, коли наші дописи зі згенерованими нейромережею зображеннями використовує російська пропаганда: "Росіяни починають говорити, що українці свідомо створюють неправдивий контент, щоб поширювати дезінформацію про російські дії в Україні. І згодом на підставі цього стверджуватимуть, що будь-які фото та інформація — це постанова. Думаю, всі пам'ятають, коли росіяни намагалися масово розганяти ідею того, що фотографії з Маріуполя — постанова".

Такі наративи впливають на іноземців та формують у них упереджену думку про російсько-українську війну. Зокрема росіяни поширювали серед іноземців маніпуляції, що жахливі фото вбитих українців з Бучі та Ірпеня — це "інсценування київського режиму для західних медіа", чим справді повпливали на частину іноземних користувачів, які з недовірою сприйняли ці кадри.

"Чим більше ми будемо створювати згенерований контент, пов'язаний з війною, тим більше буде поширюватися ця теза (що всі фото з України — це постанова) і тим більш валідною вона буде. Бо якщо вже є згенерований контент з боку українців, тоді чому реальні фотографії воєнних злочинів також не можуть бути згенерованими? Медіа я б не радила генерувати щось на чутливі теми, тому що це буде ще більше розмивати поняття того, що є реальним, а що є нереальним", — коментує експертка.

Юристка ділиться, по цій темі вони з командою багато співпрацюють з міжнародними медіа та міжурядовими організаціями, щоб постійно спростовувати наративи та доводити, що українські медіа не є упередженими, дотримуються стандартів, є надійними, висвітлюють інформацію так, як вона має бути.

"І якщо українські медіа будуть поширювати згенерований контент, то буде все тяжче з цим взаємодіяти, буде тяжче просувати ідею, що можна брати інформацію з українських медіа, а не покладатися тільки на ресурси власних міжнародних розслідувачів, репортерів і так далі", — додає вона.

Чи етично використовувати згенеровані зображення?

Нейромережа тренується генерувати зображення на основі вже раніше створеного людиною контенту. Через це в інфопросторі не згасає дискусія — чи етично використовувати штучний інтелект, коли він безплатно та без згоди авторів використовує їхні роботи у своїх цілях.

Фахівчиня відповідає, питання відкрите та складне: "Я б сказала, що питання навіть не у використанні зображень та фото як таких, а в тому, як програмується система. Наприклад, коли ми просимо згенерувати нам щось, то невідомо, на основі яких конкретно ввідних даних, шматочків, генерується конкретне зображення. Ми можемо попросити згенерувати замок з єдинорогами й не знаємо, чиє саме фото замку, чию картину єдинорога візьме система, хто саме хто буде автором ось цих матеріалів, на основі яких буде генеруватись наше зображення".

Якщо ми генеруємо самі, тут питання не тільки етики, але й дотримання законодавства про авторське право. Щоб використовувати в інформаційних цілях якусь інформацію, нам потрібен дозвіл автора.

Механізми регуляції

Усі наявні механізми регуляції розраховані на роботу розробників онлайн-платформ. Наприклад, Рада Європи розробляє проєкт про штучний інтелект, у якому рішення регуляції передбачає маркування контенту, але саме кінцевими користувачами, що частково знімає цей обов'язок з компаній. Проєкт говорить, компанії мають забезпечувати принцип прозорості, щоб користувачі розуміли, що вони взаємодіють зі штучним інтелектом і автор продукту — штучний інтелект, та забезпечити користувачів інструментами для маркування.

Такі компанії як Фейсбук, Твіттер, Гугл, Майкрософт вже запроваджують маркування, але поки на рівні бета-тестування. Наприклад, Майкрософт пропонує функцію накладання на кожний автентичний контент аналога електронного цифрового підпису. "Якщо публічні особи випускатимуть заяви, то на технічному рівні це не буде якийсь візуально видимий водяний знак, а, по суті, частина коду завантаженого відео тощо. І можна буде перевірити, чи збігається цей код з ключем, який є публічно доступним. Згенерований контент якраз цього підпису оригінальності не матиме", — розповідає юристка. Вона пропонує й інший варіант — позначати дописи на кшталт того, як зараз позначається політична реклама або оплачений допис. Однак всі ці рішення орієнтовані на добросовісних авторів.

А як в Україні?

В Україні, з правового погляду, погляду етики та Закону про медіа, поки немає відповідей, яким чином кваліфікувати згенерований контент. А також чи можна його вважати надійним і правдивим. Тетяна вважає, попри це, ми рухаємося в напрямку регуляції. Наприклад, Мінцифра, як один з кроків, давало рекомендації про відповідальність застосування штучного інтелекту в медіа.

Незабаром у країні також імплементують Акт про цифрові послуги (одна з цілей якого — забезпечити регуляцію контенту та його прозорості на онлайн-платформах). Попри те, що вони доволі загальні та базові, це рішення вводить функцію інституту довірених партнерів. Наразі такі є в Meta: Цифролаба, Internews Україна й деяких інших. Це організації, з якими платформи тісно співпрацюють для того, щоб можна було покращувати модераційні політики, вирішувати суперечливі питання. Наприклад, коли зносили хештеги "#Буча, #Ірпінь", Цифролаба активно просувала те, щоб припинили блокувати публікації лише на підставі конкретного слова. І щоб ці дописи зі свідченнями вчинення воєнних злочинів відновили.

Експертка вважає, рішення буде пропонуватися, але на це потрібен час. А поки відстежувати та регулювати згенерований контент швидше в ручному режимі.

Поради користувачам, як самостійно розпізнати згенерований контент

Проаналізувати дивні зміни в зображені, звертати увагу на:

- Те, як виглядають сережки, прикраси, як загалом виглядають вуха — все, що знаходиться поза овалом обличчя.

Сережки на таких світлинах зазвичай розпливчасті. Фото: How to recognize fake AI-generated images, Kyle McDonald

- Як виглядає фон — чи нічого не "поїхало", не розпливлося.

- Одяг — чи правильно розташована змійка, чи на худі є зав'язки, чи вони ніде не перебиваються.

- Волосся — чи не "з'їхали" пасма, чи натурально воно виглядає.

Фото: How to recognize fake AI-generated images, Kyle McDonald

- Як виглядають зіниці, так, наприклад, можна визначати діпфейки (накладання зображення на відео).

Експертка наводить приклад: на початку повномасштабного вторгнення невідомі зробили маску Кличка і зідзвонювалися з мерами інших міст Європи: Барселони, Берліна і ще кількох. Розмови тривали до 30 хвилин, доки стало зрозуміло, що це говорить не Кличко. Тому що наративи, які він говорив, абсолютно не збігалися з реальною позиціює Києва. Плюс фільтри, накладені в режимі реального часу, зазвичай не встигають адаптуватися до швидкої зміни руху чи віддзеркалення зображення — вони "лагають". Тому можна попросити людину повернути голову, якщо відео транслюється у режимі реального часу. Або вже готове відео проаналізувати в спеціальних застосунках.

- Ефект малюнку чи блюру на зображенні. Чи виглядають поверхні та обличчя глянцевими, наче відретушованими.

І найголовніша порада — якщо ви сумніваєтеся в правдивості інформації, не поширюйте її бездумно. Дотримуйтеся правил з медіаграмотності та не засмічуйте свій цифровий слід.